Les entreprises de médias et les annonceurs s'appuient chaque jour sur l'audimat pour mesurer le succès des émissions télévisées, vérifier que la taille et la composition de leur audience correspondent aux objectifs d'achat de médias et se rattraper si les chiffres ne sont pas à la hauteur. De ce point de vue, l'audimat est un indicateur qui mesure le passé, ou au mieux le présent, de la consommation télévisuelle.

Mais les entreprises médiatiques utilisent également les taux d'audience pour prédire l'avenir. Les cotes d'écoute définissent les attentes et influencent les décisions de programmation d'une saison à l'autre. Elles permettent également de fixer les tarifs publicitaires bien avant la diffusion d'une campagne. Aux États-Unis, par exemple, les chaînes de télévision vendent la majorité de leur inventaire publicitaire pour la saison lors du "upfront", un événement qu'elles n'organisent qu'une fois par an (entre mars et mai). Cela signifie que le tarif des publicités que vous voyez aujourd'hui à la télévision peut avoir été négocié il y a plus d'un an.

Afin de prévoir l'audience d'une émission dans trois, six ou douze mois, les chercheurs utilisent des modèles de prévision. Nombre de ces modèles sont utilisés depuis des années avec peu ou pas de modifications. Ils ont permis de prédire avec succès les taux d'audience et de soutenir l'échange de milliards de dollars de publicité chaque année. Mais l'évolution rapide de l'écosystème télévisuel rend de plus en plus difficile l'élaboration de modèles fiables.

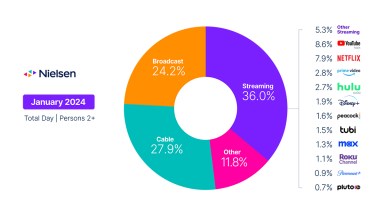

Il suffit de regarder la liste des innovations technologiques récentes dans le secteur des médias : Les téléspectateurs utilisent de plus en plus leurs ordinateurs portables, leurs tablettes et leurs smartphones pour regarder les contenus ; les services de diffusion en continu comme Netflix et Amazon Prime ont été adoptés en masse ; les nouveaux appareils connectés à la télévision sont en train de remodeler l'expérience du grand écran. Les gens changent d'heure, regardent en continu et font du "binge watching" - ils contrôlent plus que jamais les médias qu'ils consomment. Leur comportement est non seulement plus complexe, mais aussi plus imprévisible.

Chez Nielsen, nous avons accès à de nombreuses ressources de données qui mesurent la façon dont les gens consomment les médias. Avant d'ajouter des données sur la télévision numérique (en tant que données d'entrée et de sortie de nos modèles de prévision), nous voulions examiner s'il était possible d'améliorer d'abord la façon dont nous prédisions les audiences de la télévision traditionnelle, en utilisant les données de la télévision traditionnelle comme seule source. Grâce à l'audimètre national de Nielsen, nous disposons de données de haute qualité qui remontent à plusieurs années, avec une méthodologie cohérente et un panel solide de téléspectateurs représentatifs au niveau national.

Nous avons exploité ces riches données à un niveau très détaillé pour créer de nouveaux modèles prédictifs : Des variables telles que les audiences historiques Live+7 (c'est-à-dire, Les variables telles que les audiences historiques Live+7 (c'est-à-dire les audiences en direct, ainsi que les téléspectateurs jusqu'à sept jours après la diffusion initiale), les audiences C3 (les audiences commerciales qui incluent la lecture jusqu'à trois jours après), HUT (le pourcentage de ménages utilisant la télévision à un moment donné), la portée, les audiences des ménages, les audiences démographiques, le jour de la semaine, l'heure de la journée et l'identité du réseau sont quelques-unes des informations clés que nous avons utilisées comme variables d'entrée ; et nous avons capitalisé sur l'apprentissage automatique avancé et les algorithmes statistiques (tels que la régression ridge, la forêt aléatoire et le gradient boosting) pour identifier les relations pertinentes entre les données.

En collaboration avec un client, nous avons mené un certain nombre d'études de validation pour tester et valider les modèles que nous avons créés. Nous avons conçu nos modèles pour prédire les futures audiences à un niveau granulaire (blocs horaires pour de petits groupes démographiques, comme les hommes âgés de 2 à 5 ans ou les femmes de 65 ans et plus), mais nous avons également répercuté ces chiffres au niveau du réseau. Afin de comprendre les performances de nos modèles par rapport à la réalité, nous avons utilisé une période d'attente de deux trimestres pour comparer nos prévisions ainsi que les prévisions internes de notre client aux données d'audience réelles. Par exemple, nous avons prédit avec précision un taux moyen de Live+7 de 1,94 pour les personnes âgées de 30 à 34 ans sur le réseau A entre 21 heures et 22 heures le mardi au cours du deuxième trimestre 2015, en nous basant uniquement sur les données historiques jusqu'au premier trimestre 2014. Les prédictions étaient très précises au niveau du réseau, où nous avons obtenu un R-carré de 99 % (pourcentage de variance expliquée), mais elles étaient plus difficiles au niveau plus granulaire du bloc horaire ou pour certains des groupes démographiques plus petits. Cependant, même au niveau des blocs d'heures, le R-carré de notre modèle dépassait encore 95 % et était nettement supérieur à un modèle sur lequel notre client s'appuyait jusqu'alors. Sur plus de 2 000 projections diurnes, nos prévisions étaient 41 % plus précises pour le R-carré et 16 % plus précises pour le pourcentage d'erreur absolue pondérée (WAPE) - deux mesures clés de la précision des prévisions.

Nous donnerons plus de détails sur ces modèles de validation et sur les tests que nous avons effectués dans un prochain article. La principale conclusion de ce projet est que nous avons pu convertir des données comportementales volumineuses et bruyantes en caractéristiques de modélisation prédictive, et ce de manière très efficace (et automatisée). Nous devons donc continuer à repousser les limites en ajoutant de nouvelles variables d'entrée (telles que les dépenses publicitaires ou les données spécifiques aux programmes), en développant des moyens de s'adapter rapidement aux changements de programmes et de chaînes, en testant de nouvelles formes d'algorithmes de régression et de classification, ou même en combinant plusieurs modèles prometteurs en un seul.

Bien que ce projet se soit concentré sur la télévision traditionnelle, il est intéressant de noter que l'impact des données numériques se reflète dans les changements d'audience de la télévision dans les données historiques - et donc dans nos prédictions également. Mais il s'agit d'une mesure indirecte d'un effet cumulatif qui ne saurait remplacer un modèle qui se concentrerait spécifiquement sur le visionnage en direct, par exemple, ou sur le visionnage à l'aide d'une application pour smartphone. Outre les prochaines étapes décrites ci-dessus, l'utilisation de données numériques sera un élément important pour améliorer nos prévisions à l'avenir.

En fin de compte, nous devons également reconnaître que chaque client a une connaissance intime de ses programmes, ainsi qu'une forte intuition sur la façon dont ces programmes pourraient être accueillis à l'avenir. Cet "élément humain" ne doit pas être ignoré lorsque nous élaborons des modèles prédictifs et peut être particulièrement précieux lorsque nous réagissons à des changements importants et imprévus sur le marché. Un système qui intègre des données riches, de puissants algorithmes d'apprentissage automatique et une expertise dans le domaine peut obtenir de meilleurs résultats que ceux que chacun d'entre eux pourrait obtenir seul.